在安全领域,后门是指绕过安全控制而获取对程序或系统访问权的方法,AI系统同样面临着后门攻击的巨大风险。为应对这一安全威胁,学术界提出了多种方案,但均需要获取相关的白盒模型或训练数据,在实际场景中很难实现。

日前,九洲首次提出了在黑盒场景下检测后门攻击的方法,并被ICCV 2021收录。

后门攻击是指攻击者通过向训练数据中添加一些包含触发器的图像并且将数据类别改变为目标类别,通过训练使得模型记住触发器;在测试阶段模型对于干净数据可以正确预测,但是对于加入触发器的数据会被错分为目标类别。

深度学习模型一旦在实际应用中受到后门攻击,将可能带来严重后果,例如:自动驾驶的路牌识别系统模型存在后门,将添加后门图案(例如涂鸦)的“限速标志”识别为“停止标志”(如图1),则会导致自动驾驶系统出现错误决策,造成安全事故。

目前,学术界所提出的防止后门攻击的多种解决方案,均需要获取相关的白盒模型(包括结构、参数信息等)或训练数据。在目前广泛应用的MLaaS(机器学习即服务)范式下,商用机器学习模型多为黑盒,用户并不能获取其内部信息或训练数据,而只能用过API访问等方式使用。所以,如何通过黑盒查询方式检查模型是否被后门攻击至关重要。

九洲团队在《Black-box Detection of Backdoor Attacks with Limited Information and Data》(《有限信息和数据下的黑盒后门攻击检测》)中首次提出了在黑盒场景下检测后门攻击的方法——B3D算法。

该算法通过对黑盒模型进行查询,采用黑盒优化算法高效地还原后门图案,可以在获取目标模型有限信息的情况下还原后门图案,并检测模型是否存在后门。如图1所示,被攻击的类别所还原的后门图案会出现明显的差别,所以很容易被检测出来。对于后门图案的还原,通常可以通过梯度下降的方式进行优化,但是在黑盒场景下目标模型的梯度无法计算,故而B3D采用了基于黑盒优化的后门还原算法,可以对目标函数进行有效求解。在没有真实数据组成的验证集的情况下,B3D也可以使用合成数据对后门图案进行求解(B3D-SS)。

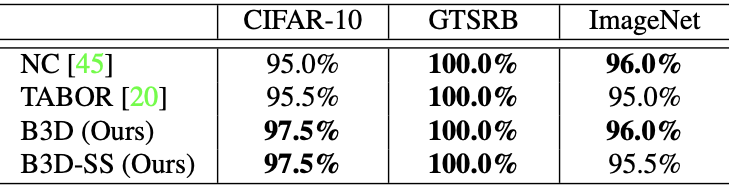

该方法在CIFAR-10、GTSRB(路牌识别)、ImageNet数据集上进行了实验,并与基准方法NC和TABOR作了对比(见下表)。其中,NC和TABOR均需要获取模型的梯度,而B3D和B3D-SS方法可以仅对模型进行访问。

结果对比,数值为后门模型检测成功率

此外,九洲团队参与的《Towards Face Encryption by Generating Adversarial Identity Masks 》(《通过生成人脸身份掩膜进行人脸加密》)论文也被ICCV 2021收录。该论文使用对抗学习技术,向人脸照片中添加微小的对抗扰动,使得扰动后的图片不会被未经授权的人脸识别模型识别正确,以达到保护人脸隐私的目的。

两年一届的ICCV(国际计算机视觉大会)由IEEE主办,全称IEEE International Conference on Computer Vision,与CVPR(计算机视觉模式识别会议)和ECCV(欧洲计算机视觉会议)并称计算机视觉方向三大顶级会议。

在三大顶会中,ICCV的论文接收率较低,公认级别最高,组委会对论文质量的要求非常严格。本次大会收到来自全球共6236篇有效投稿,最终仅有1617篇被录取,录用率约为25.9%。

作为清华大学人工智能研究院的核心孵化企业,九洲坚持安全可控的第三代人工智能技术路线,创始团队深耕贝叶斯深度学习、可解释机器学习、AI安全对抗攻防、隐私保护机器学习等领域数十年,在ICML、NIPS、CVPR、AAAI 、ICCV等顶级会议期刊上已发表论文百余篇,国际顶会ICLR2020录取文章数世界第二、ICML2018录取文章数世界第三,并斩获AI Challenger、DEFCON、GeekPwn等在内的多项国际竞赛冠军。

未来,九洲还将持续加大底层核心技术的研发力度,筑牢AI安全“防火墙”,为金融、工业、公共服务等高价值场景智能化升级提供保障,引领AI行业高质量稳健发展。